A Glimpse of Industrial Solusion

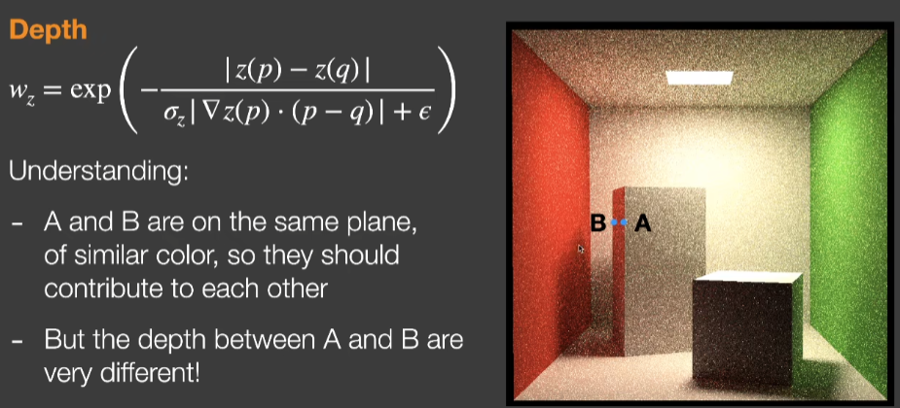

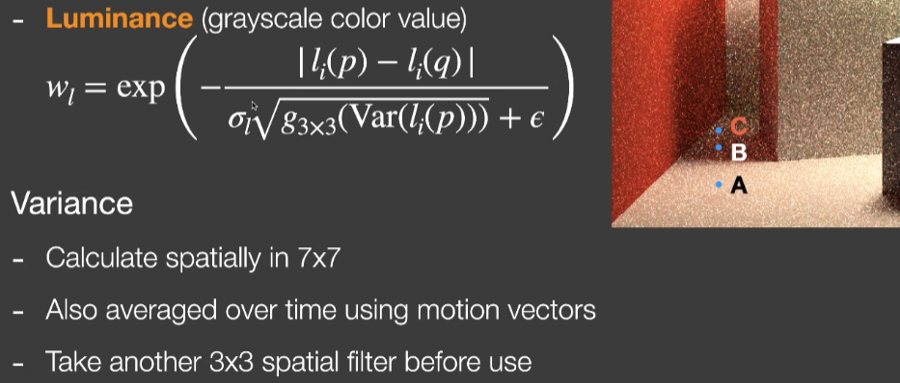

Spatiotemporal Variance-Guided Filtering (SVGF )

Recurrent denoising AutoEncoder (RAE)

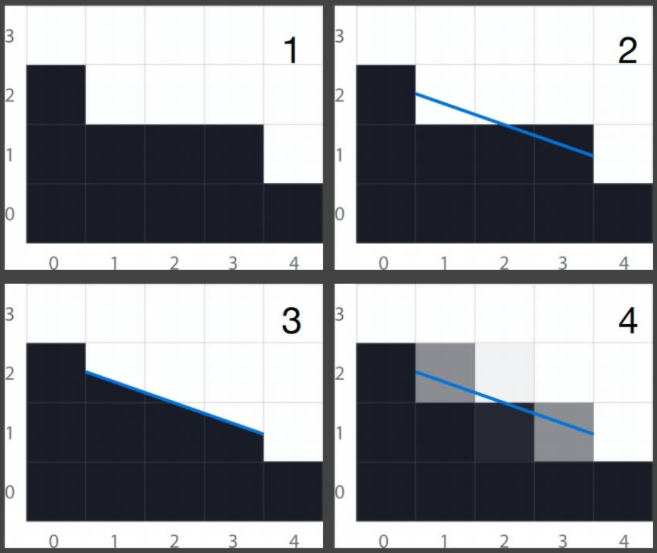

Temporal Anti-Aliasing (TAA)

Space Anti-Aliasing

Temporal Super Resolution 超分辨率方案

避免没有意义的着色

Tiled Shading

Clustered Shading

Level of Detail Solution

Geometry LOD

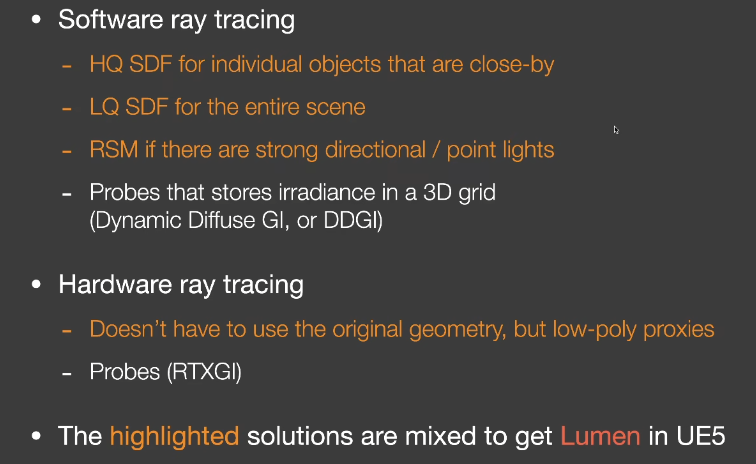

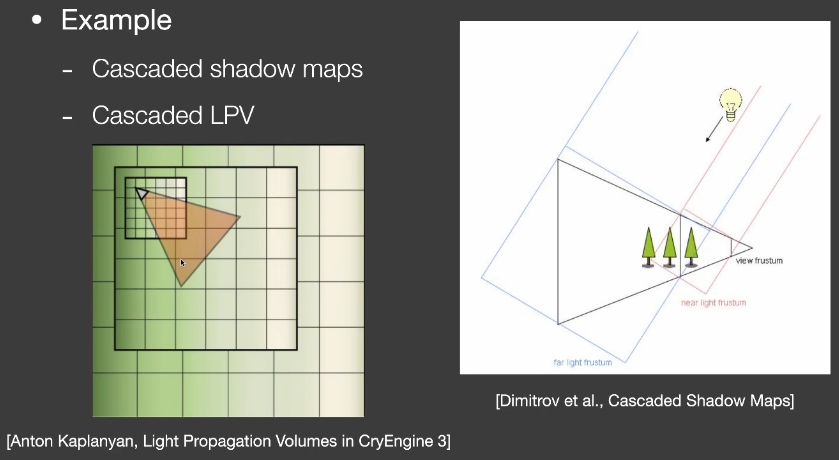

Global illumination Solution

最后更新于